DeepSeek在实际使用过程中,大家应该发现它其实对每一次的对话是有上限的,所以为了解决这个问题,笔者将DeepSeek进行了本地化部署,这样不管我有多少对话也不会受到限制。

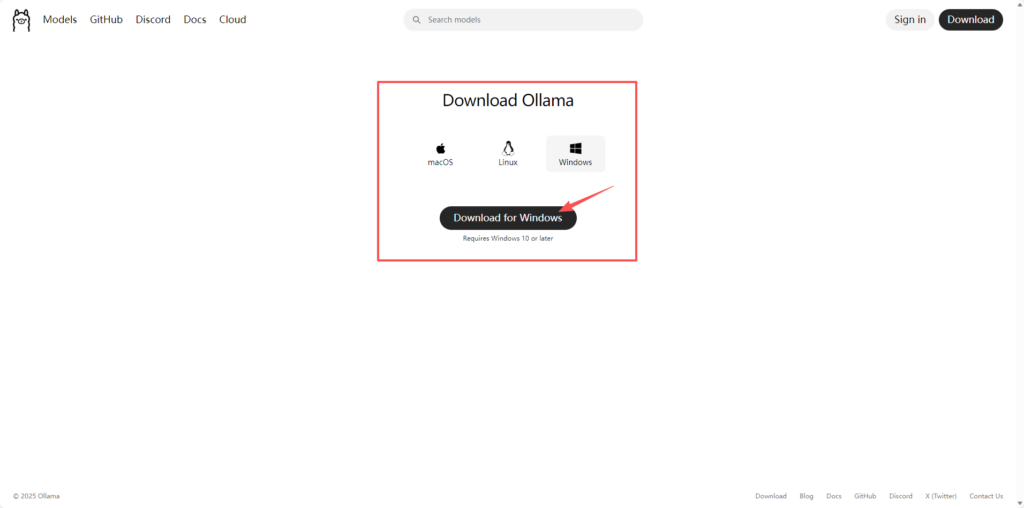

第一步:下载ollama👈点名称可以进入下载窗口

根据自己的系统下载,本人是win系统,所以选择的Windows。

但是这个网站下载东西特别慢,所以我建议大家使用下载工具去下载,否则一天都要浪费在里面

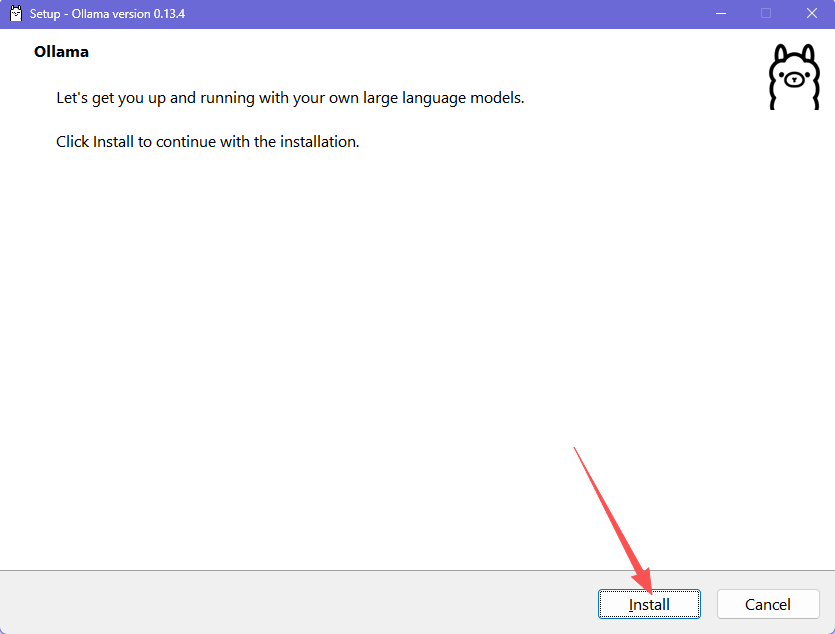

第二步:安装ollama,直接选择安装即可

注意:ollama安装完成后桌面上是没有图标的

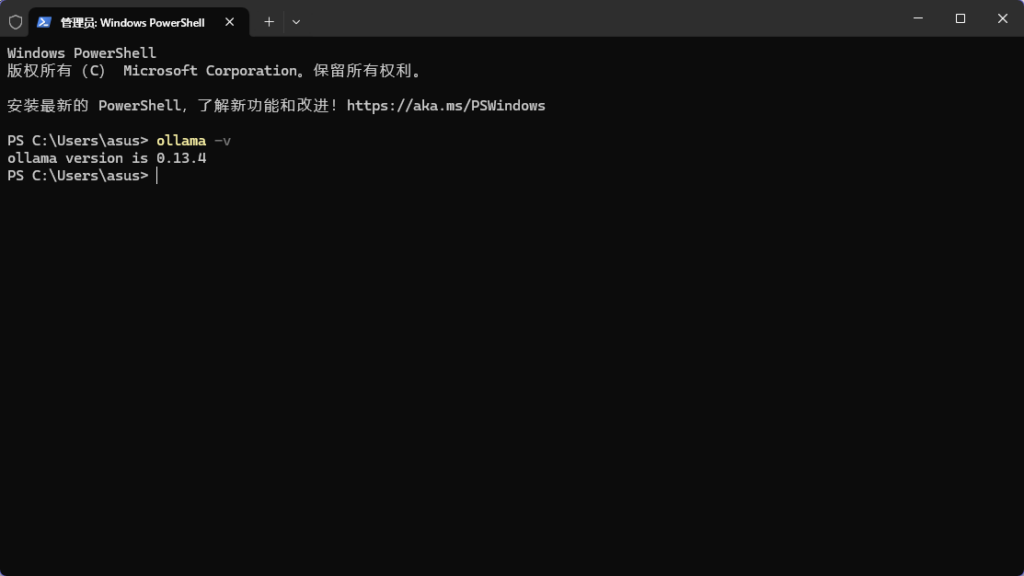

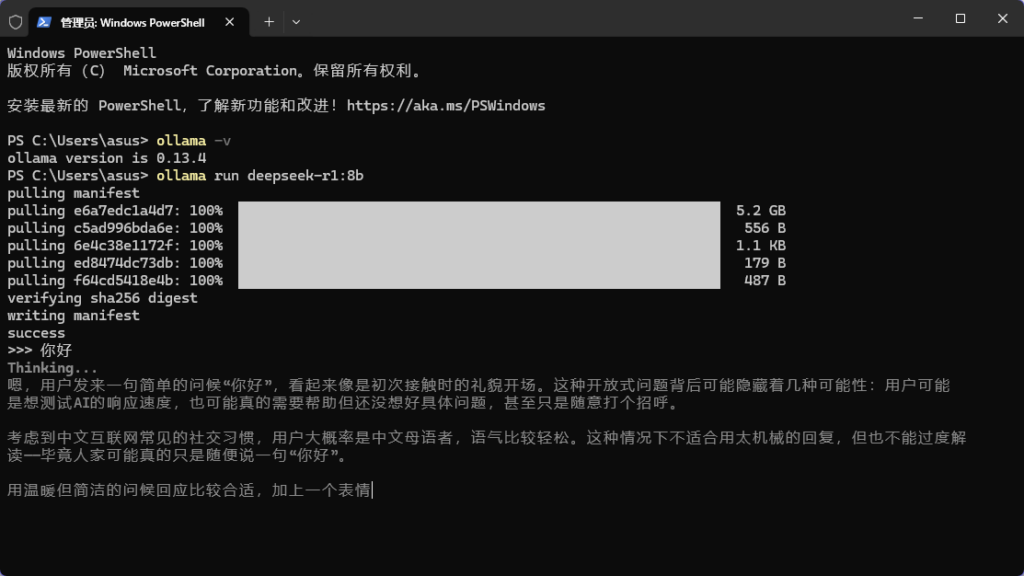

第三步:按下键盘Win + R,输入cmd进命令窗口检查ollama是否安装成功

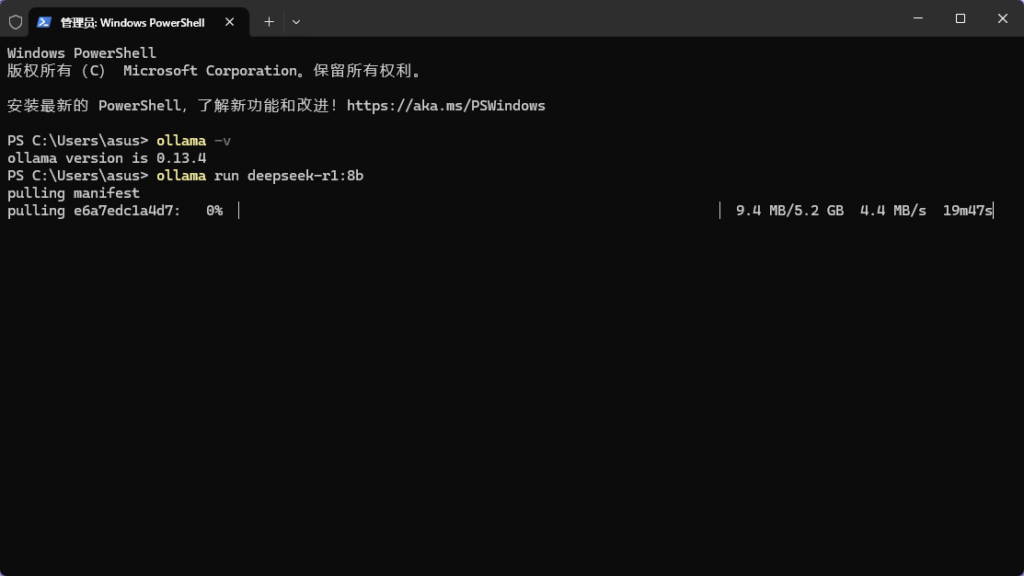

输入ollama -v(注意空格后加-v),如果出现版本号,表示安装成功

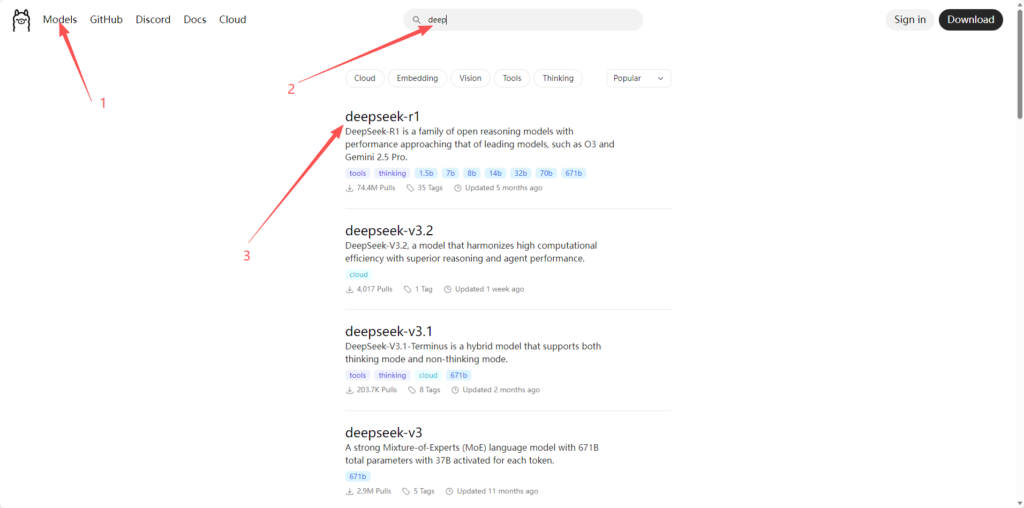

第四步:下载并运行Deepseek-R1大模型

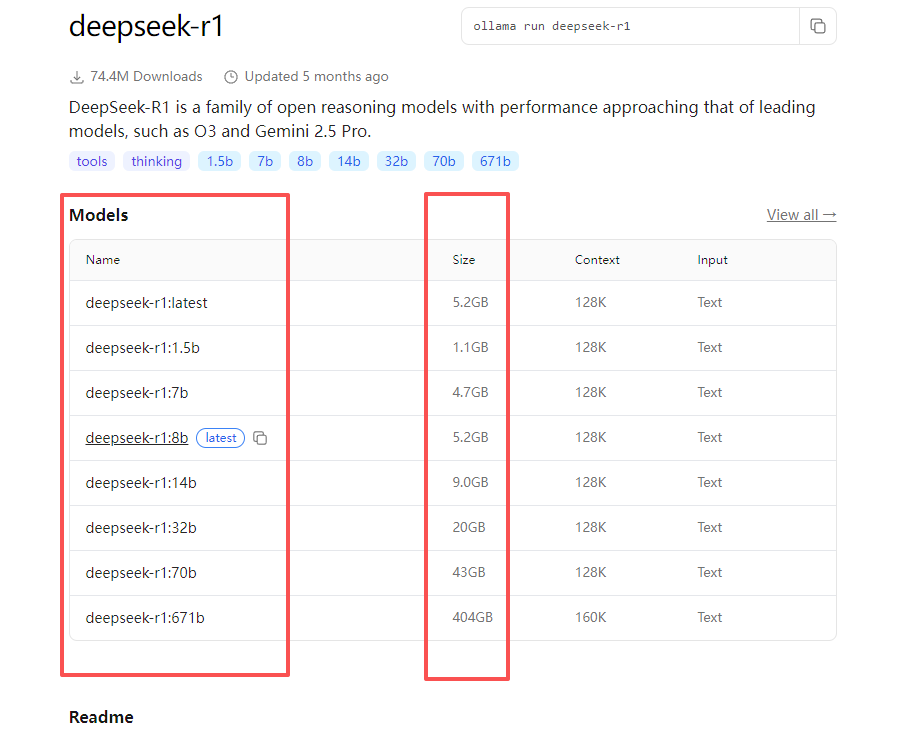

还是在刚刚的ollama网站,打开以后找到你需要的模型,不同的版本占用空间越大

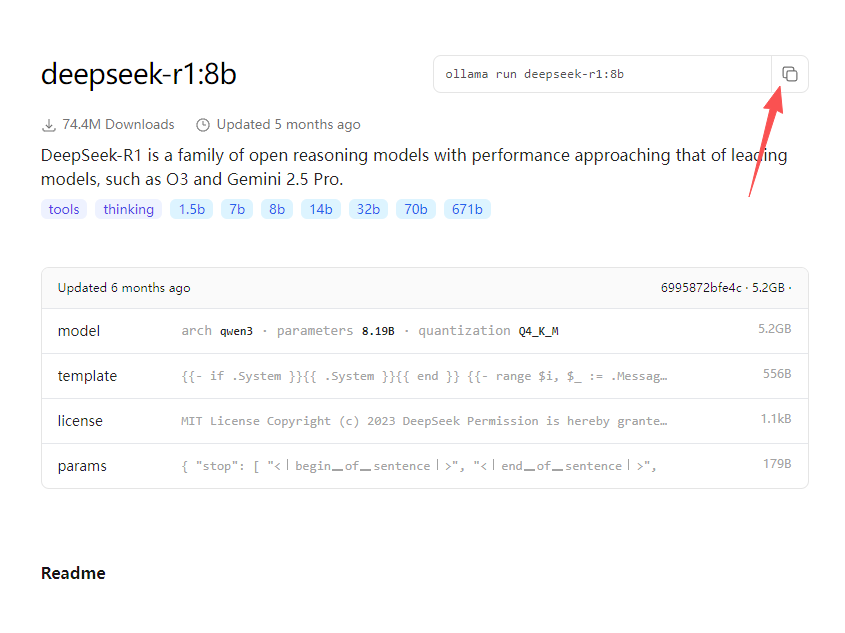

点击进入后,就可以看到各个版本,根据自己情况去选择,个人用户其实选个占用小的我觉得就够用了

选择好版本后,点击右边的复制按钮

将复制的命令粘贴到CMD命令窗口中,回车开始下载。

稍微等一会就能下好,模型下载的速度还是不错的,不要太着急

注意:窗口内的演示命令与你自己操作的可能不一样

第五步:测试完成

好了,至此你的DeepSeek就部署完成了,感谢的话点个赞吧!

进阶部分:

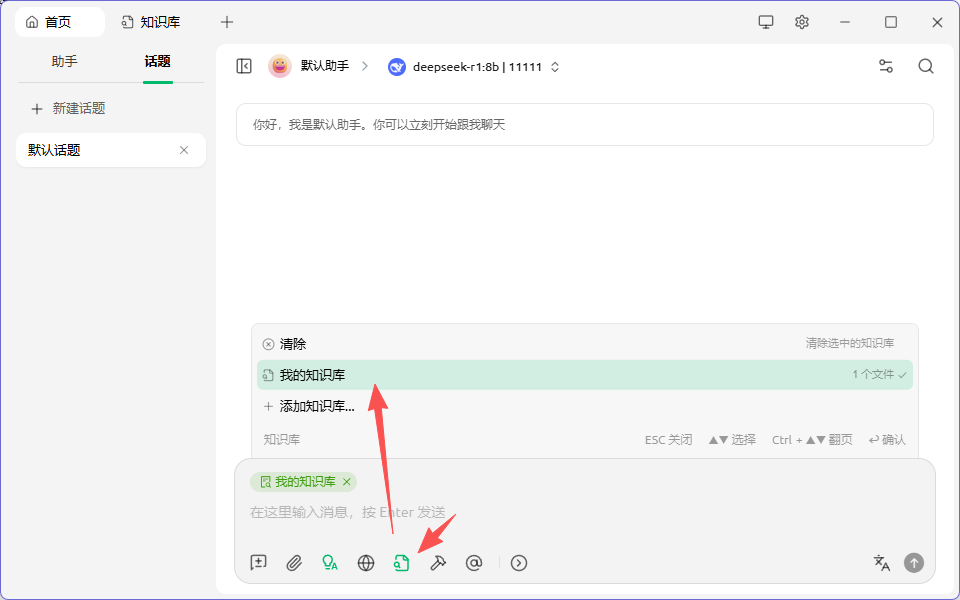

在本地部署完成以后,可以利用知识库功能,使DeepSeek的效率翻倍

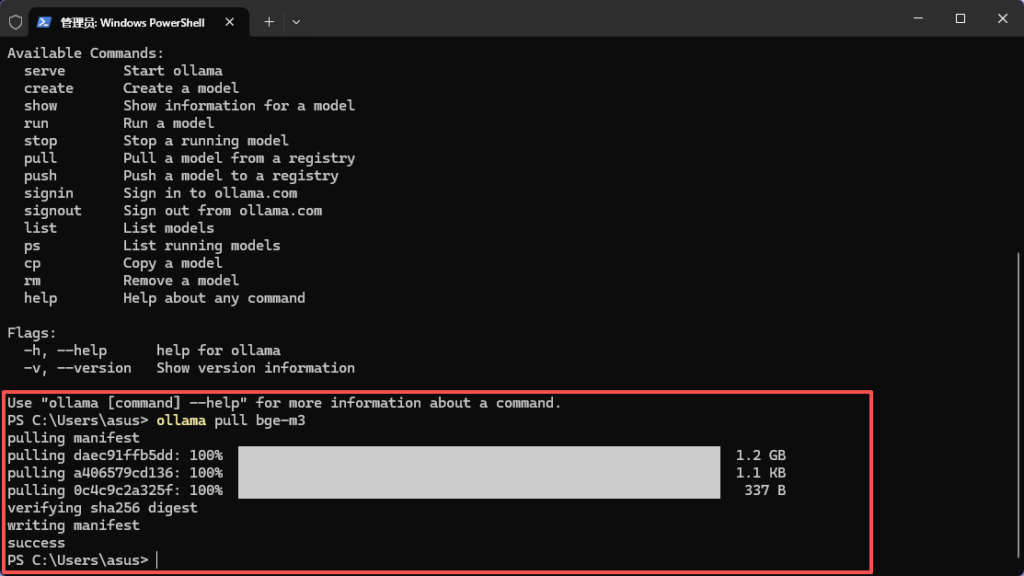

第一步:输入命令:ollama pull bge-m3 ,下载bge-m3

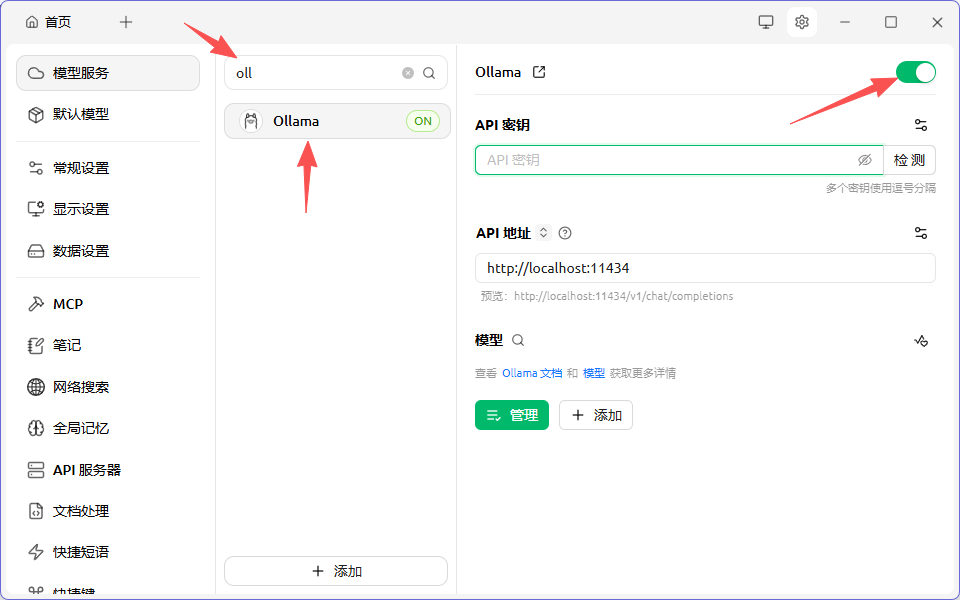

第二步:安装Cherry Studio

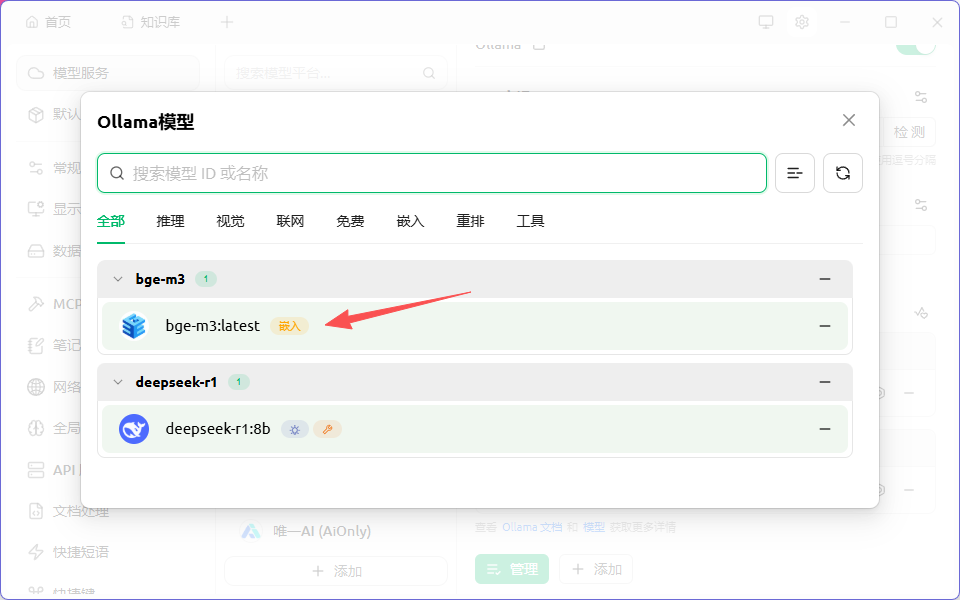

在“设置”里选择ollama,然后点“管理”,配置bge-m3嵌入模型

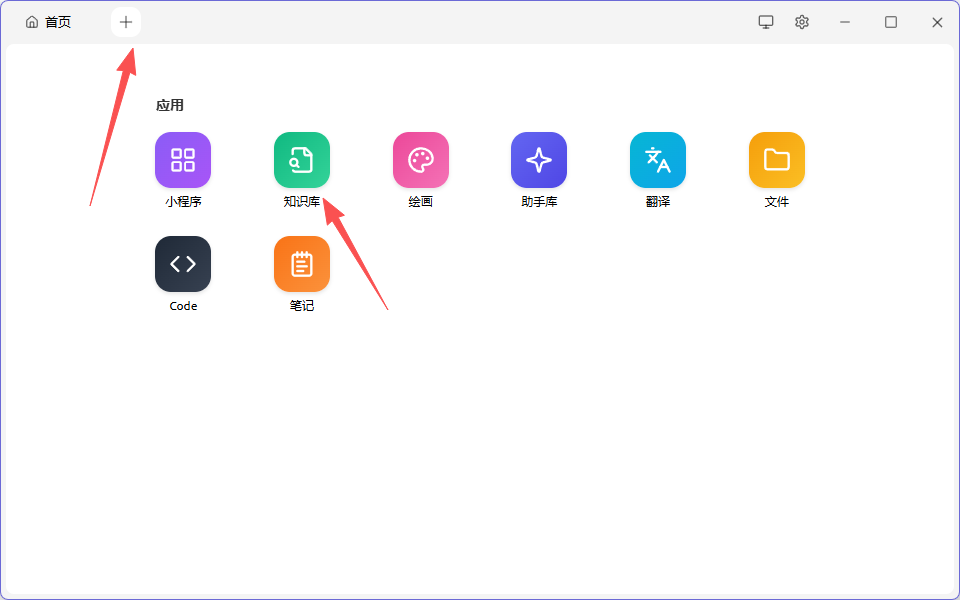

回到首页,进入知识库管理

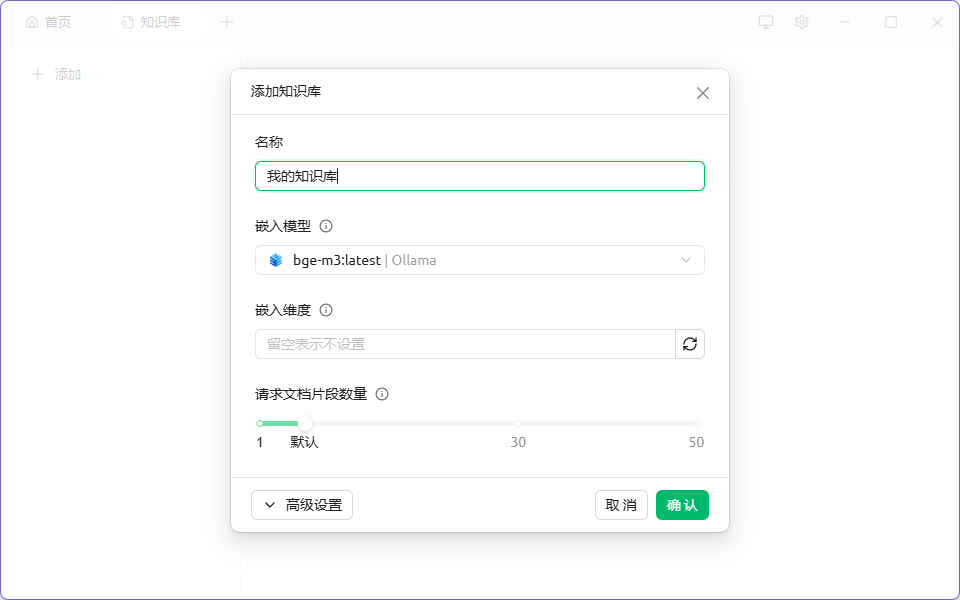

添加自己的知识库,并且在嵌入模型,选择刚才配置的bge-m3

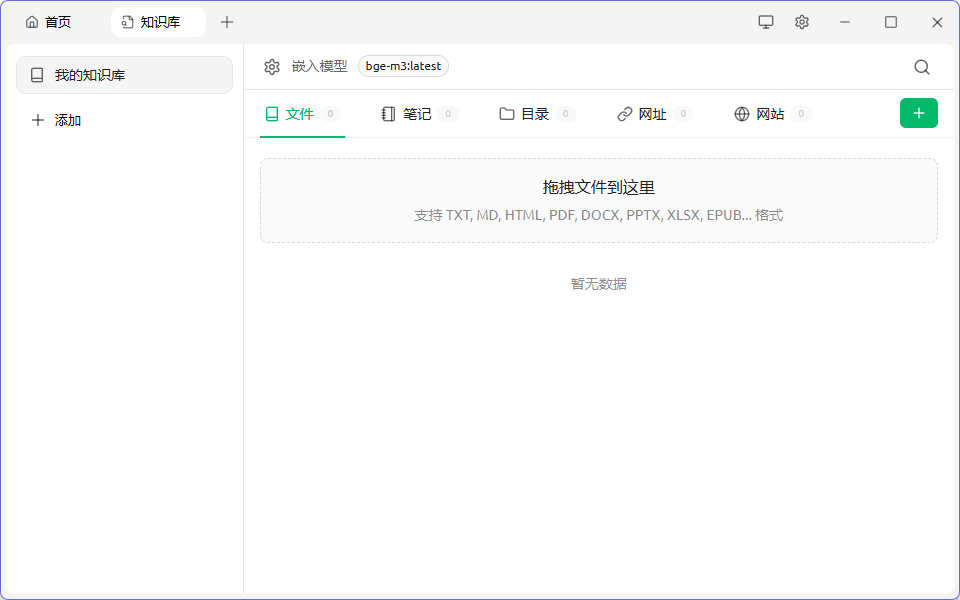

然后将你的资料添加进来就可以了

添加内容完成以后,就可以在话题中,选择知识库,然后尽情使用啦